英伟达研究团队凭借其数字头像获得“最佳展示”奖

在一场演示盛宴中,NVIDIA研究人员将四款AI模型注入到数字头像技术作品中,在SIGGRAPH 2021大会直播中展出,并获得“最佳展示”奖。

本次展览是今年以虚拟形式举办的世界大型计算机图形学大会最受期待的活动之一,庆祝跨越游戏技术、增强现实和科学可视化的各种前沿实时项目。展览包括评审团评判的一系列互动项目,主讲人来自Unity Technologies、伦斯勒理工学院、纽约大学未来现实实验室等。

NVIDIA研究团队在硅谷总部进行了直播,展示了一系列可以创造出栩栩如生的虚拟角色的AI模型,适用于带宽高效的视频会议和讲故事项目。

演示包括各种工具,可以从一张照片生成数字头像,用自然的3D面部运动制作头像动画,并将文本转换为语音。

NVIDIA应用深度学习研究副总裁Bryan Catanzaro在演讲中表示:“制作数字头像是一个非常困难、繁琐和昂贵的过程。”但是有了AI工具,“我们可以轻松地创建真实人物和卡通人物的数字化身。它可以用于视频会议、讲故事、虚拟助理和许多其他应用。”

AI在面试中表现出色

在演示中,两位英伟达研究科学家扮演了面试官和候选人的角色,并通过视频会议进行了交谈。在通话中,面试官展示了AI驱动的数字头像技术如何与面试官沟通。

扮演候选人角色的研究人员在整个过程中使用了英伟达RTX笔记本电脑,而另一名研究人员则使用了RTX A6000 GPU支持的桌面工作站。整个过程也可以在云中的GPU上运行。

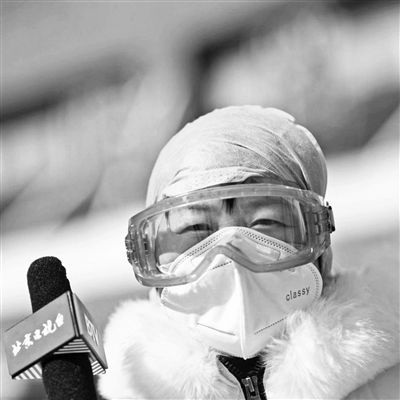

考生们坐在校园的咖啡厅里,戴着棒球帽和口罩,用Vid2Vid Cameo模型在视频通话中呈现穿着领衫、留着干净胡子的形象(见上图)。人工智能模型基于一张物体的照片创建逼真的数字化身,无需3D扫描或专门训练的图像。

他展示了另外两张照片,说:“数字头像的创建可以在瞬间完成,所以我可以用不同的照片快速创建不同的头像。”

研究人员的系统不传输视频流,只发送他的语音,然后将语音发送到NVIDIA Omniverse Audio2Face应用程序。Audio2Face可以生成头部、眼睛和嘴唇的自然运动,从而在3D头部模型上实时匹配音频输入。面部动画进入Vid2Vid Cameo,与说话人的数字头像合成自然动作。

除了逼真的数字头像,研究人员还通过Audio2Face和Vid2Vid Cameo发表演讲,为动画角色配音。他说,使用NVIDIA StyleGAN,开发者可以用卡通人物或绘画作为模型来创建无限的数字头像。

这些型号经过优化,可以在英伟达RTX图形处理器上运行,并且可以以每秒30帧的速度轻松传输视频。此外,它具有高带宽效率,因为扬声器只通过网络发送音频数据,而不是传输高分辨率视频源。

此外,研究人员表明,当咖啡店环境变得过于嘈杂时,RAD-TTS模型可以将输入消息转换为他的语音,而不是传递给Audio2Face的语音。一个突破性的基于深度学习的文本到语音转换工具,可以在几毫秒内通过任意文本输入合成生动的语音。

演示最后,研究团队展示了RAD-TTS可以合成各种声音,从而帮助开发者生动地呈现书中的人物,甚至说唱阿姆的《The Real Slim Shady》。

SIGGRAPH会议将持续到8月13日。在发布会上查看英伟达完整的活动安排,观看我们《在元宇宙中建立联系:GTC 主题演讲的制作》纪录片的首播。

编辑:jq

延伸 · 阅读

- 2021-08-13 15:41如何用万用表检测热敏电阻的质量?

- 2021-08-13 15:41普通水表和智能水表有什么区别?

- 2021-08-13 15:41中国芯片的最新发展

- 2021-08-13 15:41从唱衰到逆袭,新版iPhone SE是虚火还是真香?

- 2021-08-13 15:41Vishay IHLP电感封装可以在不饱和的情况下处理高瞬态可

- 2021-08-13 15:41光储充一体化加速升温 电池管理IC厂商再次迎来利好